Une fois n’est pas coutume, 2 mots sur ce qui se passe en ce moment dans mon SCD : au bout de 2 ans de préparation, la migration est terminée, nous avons quitté Loris et nous sommes en production sur le logiciel de gestion de bibliothèque open source Koha. Nous ne sommes pas seuls dans cette galère aventure : il s’agit d’un projet inter-universitaire, qui aboutit à un catalogue commun aux 3 universités d’Aix-Marseille. En chiffres, cela représente 705 000+ notices bibliographiques, 1 200 000+ exemplaires, 78 000+ lecteurs potentiels, dans un réseau de 53 bibliothèques (BU et bibliothèques associées).

Une fois n’est pas coutume, 2 mots sur ce qui se passe en ce moment dans mon SCD : au bout de 2 ans de préparation, la migration est terminée, nous avons quitté Loris et nous sommes en production sur le logiciel de gestion de bibliothèque open source Koha. Nous ne sommes pas seuls dans cette galère aventure : il s’agit d’un projet inter-universitaire, qui aboutit à un catalogue commun aux 3 universités d’Aix-Marseille. En chiffres, cela représente 705 000+ notices bibliographiques, 1 200 000+ exemplaires, 78 000+ lecteurs potentiels, dans un réseau de 53 bibliothèques (BU et bibliothèques associées).

Notre installation fonctionne avec le système de carte à puce des étudiants et personnels déjà à l’oeuvre dans les universités, nous interrogeons les bases de gestion des scolarités et des personnels (Apogée / Harpège) au moyen de webservices, ce qui nous permettra, à terme, d’avoir une information à jour en quasi-temps réel.

Qu’en dire de plus ? Tout n’est pas encore complètement calé, mais on peut déjà faire l’essentiel : faire des prêts/retours, récupérer les données qui redescendent du Sudoc, cataloguer… Bref rien que de très normal pour un SIGB. Quelques « innovations » intéressantes cependant – pour ce que je peux en juger, n’étant pas utilisatrice du système – du côté de l’OPAC : on peut récupérer des fils RSS sur ses requêtes, les notices ont des URLs pérennes et tout ça est compatible avec Zotero.

Pour ceux que ça intéresse (?), nous sommes sur une version quelque part entre la 3.2 et la 3.4, les décors sont de Roger Harth et les costumes de Donald Cardwell notre prestataire technique est BibLibre et l’assistance à maîtrise d’ouvrage est assurée par Doxulting.

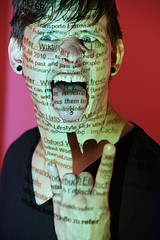

[photo : Violaine Bavent]

Archive Page 16

« La rédaction des remerciements pour mon premier livre, « Interstate 69: The Unfinished History of the Last Great American Highway,” a été une expérience grisante et un peu fatigante à la fois. Un peu comme faire un discours pour les Oscars peut-être, sans costard ni orchestre. J’ai passé beaucoup de temps sur le livre (8 ans entre les premiers entretiens et la publication), et j’ai éprouvé le besoin d’être exhaustif. J’ai donc remercié mon éditeur, mon agent, ma famille et mes amis, les gens qui m’ont guidé professionnellement, ceux qui m’ont donné un coup de main, ceux sur les canapés desquels j’ai dormi, mes professeurs, les sujets du livre… Et bien sûr j’ai remercié Google. Comment faire autrement ?

« La rédaction des remerciements pour mon premier livre, « Interstate 69: The Unfinished History of the Last Great American Highway,” a été une expérience grisante et un peu fatigante à la fois. Un peu comme faire un discours pour les Oscars peut-être, sans costard ni orchestre. J’ai passé beaucoup de temps sur le livre (8 ans entre les premiers entretiens et la publication), et j’ai éprouvé le besoin d’être exhaustif. J’ai donc remercié mon éditeur, mon agent, ma famille et mes amis, les gens qui m’ont guidé professionnellement, ceux qui m’ont donné un coup de main, ceux sur les canapés desquels j’ai dormi, mes professeurs, les sujets du livre… Et bien sûr j’ai remercié Google. Comment faire autrement ?

Cela m’a fait un peu bizarre d’exprimer de la gratitude envers une société toute-puissante d’internet, à côté des remerciements à mes parents et aux personnes que j’ai passé des heures à interviewer, mais il ne m’a pas fallu y réfléchir longtemps : pour dire les choses simplement, ce livre n’existerait pas sans Google. »

Matt Dellinger explique ensuite comment, en utilisant les alertes de Google News, la visualisation sur Google Street View, les flux RSS dans Google Reader, un compte Blogger privé pour archiver les infos intéressantes, il a pu compléter profitablement ses recherches sur le terrain. Il conclut : « Aucun site web ne peut remplacer les conversations personnelles et l’observation – mon travail a nécessité une voiture autant qu’un ordinateur – mais les outils disponibles en ligne sont une bénédiction même pour les journalistes les plus traditionnels, et ceux qui fournissent ces services doivent être crédités pour ça. Alors merci, Google. Tu as été le chien qui m’apportait mon journal tous les matins, mon équipe de tournage embarquée, mon classeur, mon bureau de poste, ma bibliothèque et ma cartothèque. J’ai de la chance. »

I’d like to thank my agent, my publisher and… Google, sur un blog du WSJ.

[Photo : rayparnova]

Retour à la bibliothèque en passant par la case Google Scholar

Published 25/08/2010 Moteurs de recherche Leave a Comment « En conclusion, Google Scholar réussit à amener les usagers vers les ressources de la bibliothèque sans qu’il soit besoin de les former à la recherche. Le fait que les résultats de recherche dans Google Scholar apparaissent dans les résultats de Google a ouvert pour les utilisateurs un chemin vers les ressources de la bibliothèque sans même qu’ils s’en rendent compte. Ce développement [le paramétrage du résolveur de liens de la bibliothèque pour l’accès aux ressources depuis Google Scholar] donne à Google Scholar un avantage indéniable sur les bases de données de la bibliothèque. Aller là où sont les utilisateurs bénéficie à la bibliothèque comme à ses utilisateurs : pour la bibliothèque, c’est un moyen de rendre les contenus qu’elle achète plus accessibles sur le web « gratuit », et donc d’en augmenter l’usage. Pour les fournisseurs de contenus avisés, qui mettent leurs contenus à dispositions sur des moteurs de recherche comme Google Scholar, c’est aussi un moyen d’augmenter les usages de ces contenus, ce qui revêt de plus en plus d’importance, en ces temps de réductions budgétaires, où les études de coût à l’usage abondent. Et faire le lien vers les ressources de la bibliothèque depuis Google, ça rend un réel service aux utilisateurs, notamment à ceux qui font leurs recherches ailleurs que sur le site de la bibliothèque : si l’on en croit les résultats de l’enquête LibQual de 2009, environ 9 189 étudiants de premier cycle utilisent les moteurs de recherche comme Google quotidiennement […] Dans ce contexte, Google Scholar joue un rôle important pour ramener les recherches vers les bases de documents en texte intégral auxquelles les bibliothèques donnent accès. »

« En conclusion, Google Scholar réussit à amener les usagers vers les ressources de la bibliothèque sans qu’il soit besoin de les former à la recherche. Le fait que les résultats de recherche dans Google Scholar apparaissent dans les résultats de Google a ouvert pour les utilisateurs un chemin vers les ressources de la bibliothèque sans même qu’ils s’en rendent compte. Ce développement [le paramétrage du résolveur de liens de la bibliothèque pour l’accès aux ressources depuis Google Scholar] donne à Google Scholar un avantage indéniable sur les bases de données de la bibliothèque. Aller là où sont les utilisateurs bénéficie à la bibliothèque comme à ses utilisateurs : pour la bibliothèque, c’est un moyen de rendre les contenus qu’elle achète plus accessibles sur le web « gratuit », et donc d’en augmenter l’usage. Pour les fournisseurs de contenus avisés, qui mettent leurs contenus à dispositions sur des moteurs de recherche comme Google Scholar, c’est aussi un moyen d’augmenter les usages de ces contenus, ce qui revêt de plus en plus d’importance, en ces temps de réductions budgétaires, où les études de coût à l’usage abondent. Et faire le lien vers les ressources de la bibliothèque depuis Google, ça rend un réel service aux utilisateurs, notamment à ceux qui font leurs recherches ailleurs que sur le site de la bibliothèque : si l’on en croit les résultats de l’enquête LibQual de 2009, environ 9 189 étudiants de premier cycle utilisent les moteurs de recherche comme Google quotidiennement […] Dans ce contexte, Google Scholar joue un rôle important pour ramener les recherches vers les bases de documents en texte intégral auxquelles les bibliothèques donnent accès. »

Google Scholar users and users behavior : and exploratory study, un article à paraître dans College & Research Libraries repéré sur la rubrique dédiée aux pre-prints de la revue.

[Photo : Dan Culleton]

« Similarités entre les bibliothèques et Google :

« Similarités entre les bibliothèques et Google :

Les 2 se sont donné pour mission d’organiser et de rendre accessible l’information mondiale.

Les 2 permettent d’obtenir de l’information numérique, depuis n’importe où et à n’importe quel moment (même quand on est encore en pyjama).

Les 2 contiennent des livres, des articles, des vidéos, de la musique, des images et bien d’autres choses encore, couvrant toutes les périodes de l’histoire.

Les 2 proposent des outils pour aider à cibler et à affiner les recherches dont la plupart des utilisateurs ignore l’existence.

Les 2 ont des blogs.

Les 2 expérimentent de nouvelles technologies.

Les 2 lancent des outils super-cool dont, au bout du compte, il s’avère que personne n’a besoin.

Les 2 permettent à la fois d’économiser du temps et d’en gaspiller, souvent au cours de la même journée.

Les 2 comportent de l’information de qualité, ainsi que beaucoup d’informations obsolètes, inutiles, fausses ou biaisées.

Différences entre les bibliothèques et Google :

Les bibliothèques protègent votre vie privée.

Les bibliothèques ne souhaitent pas « améliorer votre expérience de consommateur ».

Les bibliothèques s’opposeraient à ce qu’un éditeur entre dans la bibliothèque et supprime ou modifie les livres qu’il a publiés.

Les bibliothèques veulent retaper le fair use pour qu’il soit en bon état*, mais pas au prix d’un procès ; la plupart des bibliothèques ne peut pas se permettre d’être poursuivie en justice.

Les bibliothèques savent qu’elles ne peuvent pas diffuser toute l’information qu’elles voudraient.

Les bibliothèques doivent satisfaire des acteurs locaux, et pas des actionnaires.

Les bibliothèques pourront vous dire combien elles ont de documents dans leurs collections.

Les bibliothèques répondront aux questions par téléphone.

Les bibliothèques vous diront quels sont leur projets en cours. »

Barbara Fister, Some of These Things Are Not Like the Others…

* Si quelqu’un trouve mieux pour traduire « Libraries want to stretch fair use so it’s in good shape », je prends 😉

[Photos : Clindstedt’s]

– Elsevier teste la « validation communautaire » avec PeerChoice : pendant 3 mois, les articles soumis pour publication à la revue Chemical physics letters sont proposés à la validation de qui veut, du moment qu’il est enregistré – et qu’il a quelque expertise dans le domaine, cela va de soit. C’est une option offerte en parallèle au système de validation par les pairs traditionnels (où les spécialistes du domaine sont sélectionnés puis invités à valider les articles par le comité éditorial). On n’est pas encore dans la transparence complète (c’est pas de l’open peer-review), mais c’est un pas vers une ouverture à des modes de validation alternatifs, qu’il est intéressant de signaler.

– 20% des articles scientifiques publiés en 2008 étaient accessibles librement en 2009, soit sur le site de l’éditeur (8%), soit dans une archive ouverte (12%), selon cette étude publiée dans PLoS One. Mais puisqu’on vous dit que l’Open Access augmente la visibilité de la recherche…

– Springer lance sa collection de revues en open Access : SpringerOpen, c’est son nom, proposera un portefeuille de revues – dont on ne connaît pas encore la taille – entièrement en libre accès, et dont les contenus seront sous licence Creative Commons. Apparemment cette collection se veut « un complément entre le portefeuille historique des revues Springer et la liste (croissante) de plus de 200 titres en sciences de la vie et sciences biomédicales de BioMed Central ». Par ailleurs 2011 devrait voir les premiers effets du modèle « auteur-payeur » de Springer sur ses titres participant au programme OpenChoice : a priori une trentaine de revue a proposé un nombre significatif de ses articles en libre accès – financé par les auteurs, donc -, ce qui aura pour conséquence une baisse des tarifs des abonnements l’an prochain.

– Le JISC nous offre une synthèse très complète sur l’Open Access, avec définitions, études de cas, chronologie et rappel du travail de recherche mené au sein du JISC sur l’OA. Brilliant.

– Le JISC nous offre une synthèse très complète sur l’Open Access, avec définitions, études de cas, chronologie et rappel du travail de recherche mené au sein du JISC sur l’OA. Brilliant.

– Une source bien informée me signale que les définitions sur l’open access (institutional repository, etc.) vont officiellement faire leur entrée dans les normes internationales, notamment la 2789 statistiques de bibliothèques qui est en cours de révision. Stay tuned.

DOC ELEC STUFF

– Avis de grand frais sur les prix – en ces temps caniculaires, qui s’en plaindrait ? – des revues scientifiques : certains éditeurs, conscients de l’impact de la crise économique sur les budgets publics, s’engagent à geler leurs tarifs pour l’année à venir, ils sont priés de se signaler sur ce message de Liblicense, pour que la Medical library Association puisse en dresser la liste, comme elle l’avait fait l’an dernier.

– L’accès à la base de données statistiques de la FAO – FAOSTAT – est désormais libre et gratuit.

L’OA « vert » n’est pas la panacée

Published 25/07/2010 Archives Ouvertes , Open Access Leave a Comment « La voie « verte » vers le libre accès est simple : pour chaque article de revue scientifique, il faut qu’au moins un des auteurs fasse le nécessaire pour s’assurer que l’article en question est accessible en ligne librement, où que ce soit. Ils peuvent le déposer dans PubMed Central, ou bien mettre le pdf ou leur propre version de travail sur leur site web. Cependant, la méthode préférée de nombreux défenseurs du libre accès « vert » reste le dépôt dans une archive institutionnelle : chaque bibliothèque universitaire gère sa propre base de données des publications des chercheurs qui y sont affiliés. C’est effectivement une solution au problème de l’impossibilité d’accès aux articles que l’on souhaite lire.

« La voie « verte » vers le libre accès est simple : pour chaque article de revue scientifique, il faut qu’au moins un des auteurs fasse le nécessaire pour s’assurer que l’article en question est accessible en ligne librement, où que ce soit. Ils peuvent le déposer dans PubMed Central, ou bien mettre le pdf ou leur propre version de travail sur leur site web. Cependant, la méthode préférée de nombreux défenseurs du libre accès « vert » reste le dépôt dans une archive institutionnelle : chaque bibliothèque universitaire gère sa propre base de données des publications des chercheurs qui y sont affiliés. C’est effectivement une solution au problème de l’impossibilité d’accès aux articles que l’on souhaite lire.

Ca va vous paraître une hérésie, mais le problème de l’accès n’est pas intéressant. Les éditeurs commerciaux butés ont raison quand ils disent que la plupart des gens peuvent lire la plupart des articles qui les intéressent. Oui, cela signifie envoyer des messages aux auteurs, pirater entre amis, et emprunter des mots de passe, et oui, c’est un vrai problème, et non, les éditeurs commerciaux n’ont aucune excuse pour ne rien faire contre ça. Mais ce n’est plus un problème intéressant. Nous laisser lire un article librement, sans avoir à se connecter ou à harceler l’auteur au bout de 12 mois, ce n’est pas une révolution.

Il y a d’autres problèmes tout aussi ennuyeux dans le domaine de la publication scientifique que le libre accès « vert » ne résout pas. Comme par exemple trouver comment les bibliothèques universitaires peuvent échapper aux éditeurs parasites (ceux qui ne jurent que par l’accès sur abonnement), qui sont en train de tuer à petit feu leurs hôtes sans défense. Le libre accès « vert » envoie à ces éditeurs parasites le message qu’ils peuvent continuer à vider les bibliothèques de leurs budgets en leur vendant des bouquets d’abonnements à des revues de faible qualité que peu de gens veulent lire, du moment qu’ils ouvrent l’accès aux articles au bout de 12 mois.

C’est maintenant, alors que les bibliothèques sont confrontées à leurs plus grandes restrictions budgétaires depuis le début de la crise, le moment idéal pour qu’elles aient le cran d’intervenir, de dire « non », et de se débarrasser de ces parasites une bonne fois pour toutes, avant que quelqu’un n’arrive et ne les bâillonne derrière un énorme sparadrap. Les étudiants devraient se révolter en apprenant qu’ils vont devoir se passer de manuels et d’ordinateurs parce que leurs bibliothèques préfèrent dépenser plusieurs dizaines de milliers d’euros pour un bouquet d’obscures revues de seconde zone. Au lieu de cela, nous sommes distraits par le libre accès « vert », parce qu’on nous dit que c’est de cela que la recherche a désespérément besoin. »

Joe Dunkley dans « Green is no goal« , sur Journalology. Il évoque ensuite les « vraies révolutions » pour la recherche : la diffusion ouverte de données dans des formats structurés (il cite l’exemple de ce qui a été fait en génomique), et l’open notebook science (la science « ouverte », dont les partisans diffusent librement leurs travaux, recherches et expérimentations en cours, en toute transparence), susceptible de modifier profondément selon lui la manière de faire de la recherche.

[photo : gfpeck]

Ce sont les résultats d’une enquête menée auprès des bibliothécaires membres de Webjonction, la communauté pédagogique d’OCLC, à propos de leur usage des outils en ligne.

Curieux : un bibliothécaire sur 2 n’utilise jamais les fils RSS. Et visiblement les listes de diffusion ont encore de beaux jours devant elles : elles sont utilisées quotidiennement par un bibliothécaire sur 2, voire 3 sur 4 dans les BU.

Extrait de l’interview de Claudio Aspesi, analyste financier à propos des évolutions possibles pour Elsevier, par Richard Poynder sur son blog Open and shut ? – je vous conseille de le lire en entier, si vous vous intéressez aux questions de doc électronique – :

Extrait de l’interview de Claudio Aspesi, analyste financier à propos des évolutions possibles pour Elsevier, par Richard Poynder sur son blog Open and shut ? – je vous conseille de le lire en entier, si vous vous intéressez aux questions de doc électronique – :

« RP: Dans un rapport publié en mars, vous disiez « Reed Elsevier semble nier l’ampleur du problème pouvant affecter l’édition scientifique, et une approche plus en profondeur sur cette question serait la bienvenue. » Pouvez-vous nous en dire plus sur ce à quoi vous faites allusion ?

CA: Si – et je tiens à souligner le « si » – les contraintes budgétaires sur les bibliothèques universitaires résultent en plusieurs années de faible augmentation, voire d’absence d’augmentation des revenus, les éditeurs devront, au minimum, réduire fortement leurs coûts de production.

Si les contraintes budgétaires conduisent à des suppressions massives de contrats de type « big deal », et à une offre de nouveaux contrats à 20-30% de dépenses en moins, les éditeurs auront l’obligation de s’adapter. Aussi longtemps que les gestionnaires sembleront croire (si l’on en juge leurs déclarations publiques) qu’il n’y a aucune probabilité pour que leurs revenus restent inchangés pour les nombreuses années à venir, il faudra se demander s’il existe un plan B, qui en est responsable, et quel type d’événement pourront le déclencher.

Il y a également le fait que les arguments qu’Elsevier a mis en avant par le passé à propos de l’OA ne sont pas convaincants : par exemple, quand Reed Elsevier affirme que l’OA est voué à l’échec à cause du besoin de validation par les pairs, la société ignore le fait que la plupart des partisans de l’OA soutiennent la dissemination de cette validation.

RP: Je pense que ce que vous dites, au fond, c’est que le groupe est en déni face à l’Open Access (OA), et à son impact probable sur sa rentabilité future. En quoi l’OA est-il une menace pour l’avenir d’Elsevier ?

CA: L’OA n’a pas besoin d’être une menace. En fait, je pense qu’un passage vers l’OA « en or » (Gold OA) pourrait être bénéfique à Elsevier : si les revues proposaient des coûts de publication correspondant globalement aux revenus que la compagnie perçoit actuellement, elle maintiendrait son niveau de revenu, pour un coût vraisemblablement moindre.

La véritable menace vient de l’auto-archivage des revues validées par les pairs [Green OA]. C’est cela qui rend SCOAP, le modèle développé par la communauté des physiciens, tellement perturbant : il réduit le rôle de l’éditeur à la gestion du processus de validation, avec éventuellement un peu de mise en page. Cela nécessite des coûts plus faibles, et nie la valeur du facteur d’impact.

RP: Alors quel est le fond du problème auquel fait face Elsevier ?

CA: La société a élaboré un modèle économique sur un principe d’augmentations de revenu annuelles, justifiées et donc financées par le lancement continu de nouveaux titres. Cela a bien marché (en tout cas pour Elsevier) tant que les bibliothécaires ont pu trouver l’argent nécessaire (quel qu’ait pu être leur mécontentement croissant de l’augmentation des dépenses). Cela ne peut pas durer si l’on continue à restreindre les budgets des bibliothèques. »

[photo : deni]